Коэффициент внутриклассовой корреляции (ICC) используется для измерения надежности оценок в исследованиях, в которых участвуют два или более оценщиков.

Значение ICC может варьироваться от 0 до 1, где 0 указывает на отсутствие надежности среди оценщиков, а 1 указывает на идеальную надежность среди оценщиков.

Проще говоря, ICC используется для определения того, могут ли элементы (или предметы) быть надежно оценены разными оценщиками.

Существует несколько различных версий ICC, которые можно рассчитать в зависимости от следующих трех факторов:

- Модель: односторонние случайные эффекты, двусторонние случайные эффекты или двусторонние смешанные эффекты

- Тип отношений: согласованность или абсолютное согласие

- Единица измерения: один оценщик или среднее значение оценщиков.

Вот краткое описание трех разных моделей :

1. Модель односторонних случайных эффектов. Эта модель предполагает, что каждый субъект оценивается отдельной группой случайно выбранных оценщиков. Используя эту модель, оценщики считаются источником случайных эффектов. Эта модель редко используется на практике, поскольку для оценки каждого предмета обычно используется одна и та же группа оценщиков.

2. Модель двусторонних случайных эффектов. Эта модель предполагает, что группа из k оценщиков случайным образом выбирается из популяции и затем используется для оценки субъектов. Используя эту модель, и оценщики, и испытуемые считаются источниками случайных эффектов. Эта модель часто используется, когда мы хотим обобщить наши результаты для любых оценщиков, которые похожи на оценщиков, использованных в исследовании.

3. Модель двусторонних смешанных эффектов. Эта модель также предполагает, что группа из k оценщиков случайным образом выбирается из популяции и затем используется для оценки субъектов. Однако эта модель предполагает, что группа оценщиков, которую мы выбрали, является единственной интересующей нас оценкой, а это означает, что мы не заинтересованы в распространении наших результатов на каких-либо других оценщиков, которые также могут иметь сходные характеристики с оценщиками, использованными в исследовании.

Вот краткое описание двух различных типов отношений , которые нам может быть интересно измерить:

1. Постоянство: нас интересуют систематические различия между оценками судей (например, ставили ли судьи низкие или высокие оценки одинаковым предметам?)

2. Абсолютное согласие: нас интересует абсолютная разница между оценками судей (например, какова абсолютная разница в оценках между судьей А и судьей Б?)

Вот краткое описание двух различных единиц измерения , которые могут быть нам интересны:

1. Один оценщик: нас интересует только использование оценок одного оценщика в качестве основы для измерения.

2. Среднее значение оценок: мы заинтересованы в использовании среднего значения оценок всех судей в качестве основы для измерения.

Примечание. Если вы хотите измерить уровень согласия между двумя оценщиками, каждый из которых оценивает элементы по дихотомическому результату , вам следует вместо этого использовать каппу Коэна .

Как интерпретировать коэффициент внутриклассовой корреляции

Вот как интерпретировать значение коэффициента внутриклассовой корреляции согласно Ку и Ли :

- Менее 0,50: низкая надежность

- От 0,5 до 0,75: умеренная надежность.

- Между 0,75 и 0,9: хорошая надежность

- Более 0,9: превосходная надежность

В следующем примере показано, как на практике рассчитать коэффициент внутриклассовой корреляции.

Пример: расчет коэффициента внутриклассовой корреляции

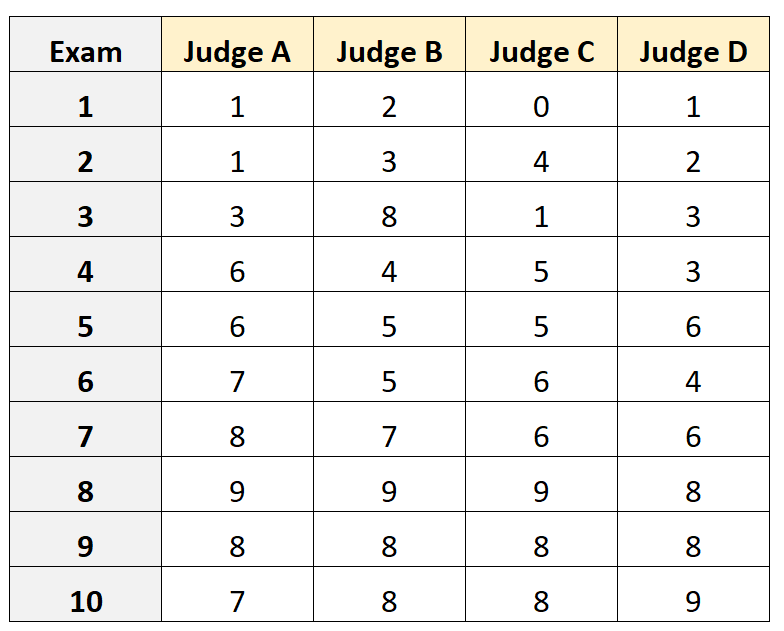

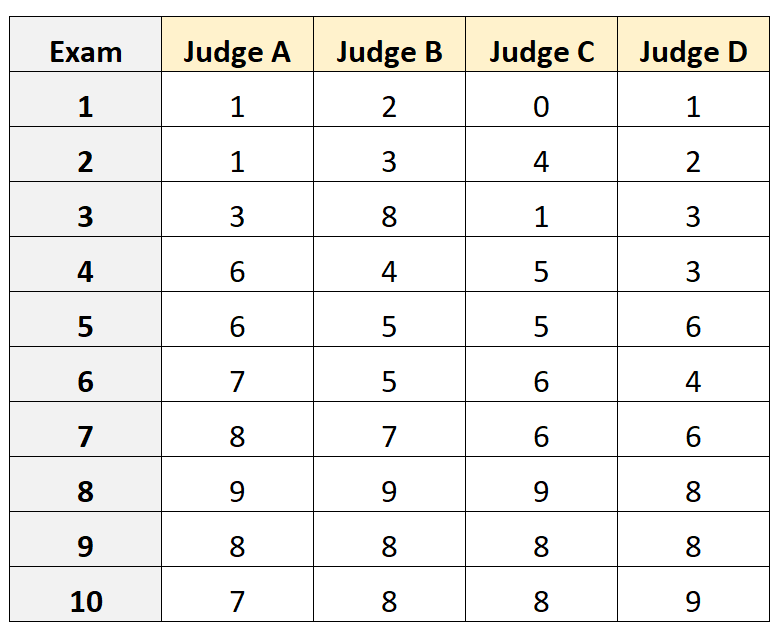

Предположим, четырех разных судей попросили оценить качество 10 различных вступительных экзаменов в колледж. Результаты показаны ниже:

Предположим, четыре судьи были выбраны случайным образом из группы квалифицированных судей вступительных экзаменов, и что мы хотели бы измерить абсолютное согласие между судьями и что мы заинтересованы в использовании рейтингов с точки зрения одного оценщика в качестве основы для нашего измерения.

Мы можем использовать следующий код в R, чтобы соответствовать модели двусторонних случайных эффектов , используя абсолютное согласие как отношение между оценщиками и используя единицу измерения в качестве нашей единицы интереса:

#load the interrater reliability package

library (irr)

#define data

data <- data.frame(A=c(1, 1, 3, 6, 6, 7, 8, 9, 8, 7),

B=c(2, 3, 8, 4, 5, 5, 7, 9, 8, 8),

C=c(0, 4, 1, 5, 5, 6, 6, 9, 8, 8),

D=c(1, 2, 3, 3, 6, 4, 6, 8, 8, 9))

#calculate ICC

icc(data, model = " twoway", type = " agreement", unit = " single ")

Model: twoway

Type : agreement

Subjects = 10

Raters = 4

ICC(A,1) = 0.782

F-Test, H0: r0 = 0 ; H1: r0 > 0

F(9,30) = 15.3 , p = 5.93e-09

95%-Confidence Interval for ICC Population Values:

0.554 < ICC < 0.931

Коэффициент внутриклассовой корреляции (ВКК) оказывается равным 0,782 .

Основываясь на эмпирических правилах интерпретации ICC, мы пришли бы к выводу, что ICC, равный 0,782 , указывает на то, что экзамены могут быть оценены с «хорошей» надежностью разными оценщиками.

Дополнительные ресурсы

В следующих учебных пособиях подробно объясняется, как рассчитать ICC в различных статистических программах:

Как рассчитать коэффициент внутриклассовой корреляции в Excel

Как рассчитать коэффициент внутриклассовой корреляции в R

Как рассчитать коэффициент внутриклассовой корреляции в Python