Сбалансированная точность — это метрика, которую мы можем использовать для оценки производительности модели классификации .

Он рассчитывается как:

Сбалансированная точность = (Чувствительность + Специфичность) / 2

куда:

- Чувствительность : «истинный положительный показатель» — процент положительных случаев, которые модель способна обнаружить.

- Специфичность : «истинный отрицательный показатель» — процент отрицательных случаев, которые модель способна обнаружить.

Эта метрика особенно полезна, когда два класса несбалансированы, то есть один класс появляется намного больше, чем другой.

В следующем примере показано, как вычислить сбалансированную точность на практике, и показано, почему это такая полезная метрика.

Пример. Расчет сбалансированной точности

Предположим, спортивный аналитик использует модель логистической регрессии, чтобы предсказать, попадут ли 400 разных баскетболистов из колледжа в НБА.

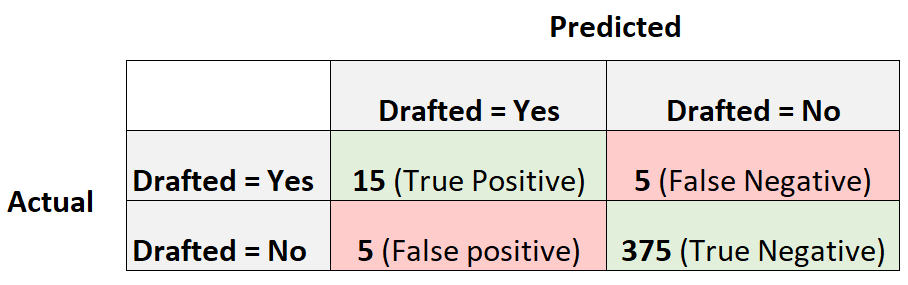

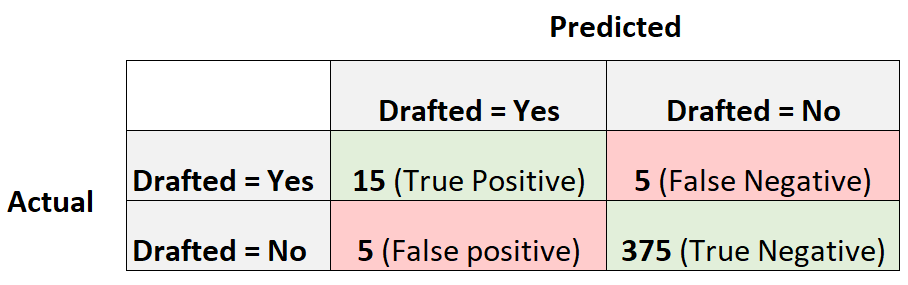

Следующая матрица путаницы суммирует прогнозы, сделанные моделью:

Чтобы рассчитать сбалансированную точность модели, мы сначала рассчитаем чувствительность и специфичность:

- Чувствительность : «истинно положительный показатель» = 15/(15 + 5) = 0,75.

- Специфичность : «Истинно отрицательный показатель» = 375 / (375 + 5) = 0,9868.

Затем мы можем рассчитать сбалансированную точность как:

- Сбалансированная точность = (Чувствительность + Специфичность) / 2

- Сбалансированная точность = (0,75 + 9868) / 2

- Сбалансированная точность = 0,8684

Сбалансированная точность модели оказывается равной 0,8684 .

Обратите внимание, что чем ближе сбалансированная точность к 1, тем лучше модель способна правильно классифицировать наблюдения.

В этом примере сбалансированная точность довольно высока, что говорит нам о том, что модель логистической регрессии довольно хорошо предсказывает, попадут ли игроки колледжа в НБА.

В этом сценарии, поскольку классы настолько несбалансированы (20 игроков были выбраны, а 380 игроков не выбраны), сбалансированная точность дает нам более реалистичную картину того, насколько хорошо работает модель, по сравнению с общей метрикой точности.

Например, мы рассчитали бы точность модели как:

- Точность = (TP + TN) / (TP + TN + FP + FN)

- Точность = (15 + 375) / (15 + 375 + 5 + 5)

- Точность = 0,975

Точность модели составляет 0,975 , что звучит очень высоко.

Однако рассмотрим модель, которая просто предсказывает, что каждый игрок не будет выбран на драфте. Это будет иметь точность 380/400 = 0,95.Это лишь немного ниже точности нашей модели.

Сбалансированная оценка точности 0,8684 дает нам лучшее представление о том, насколько хорошо модель способна предсказывать оба класса.

То есть это дает нам лучшее представление о том, насколько хорошо модель способна предсказывать игроков, которые не будут выбраны, и тех, кто будет выбран.

Дополнительные ресурсы

В следующих руководствах объясняется, как создать матрицу путаницы в различных статистических программах:

Как создать матрицу путаницы в Excel

Как создать матрицу путаницы в R

Как создать матрицу путаницы в Python